ทำไมน่ะหรือ ?

ก่อนอื่นต้องเท้าความก่อนว่าคอมพิวเตอร์ตั้งแต่สมัยโบราณ เราเริ่มมาจากจอขาวดำ (สี 1 บิต) และเริ่มมีสีจาก 4 สี (CGA) ไล่มาเป็น EGA และ VGA จนปัจจุบันมาถึง True color ซึ่งมีสี 24-bit และอยู่ตัวมาเป็นยี่สิบปีได้แล้วมั้ง....

สีแบบ 24-bit (Channel ละ 8 bit ไม่นับ Alpha) เป็นมาตรฐานที่แพร่หลาย สามารถไล่ระดับสีได้ 16.7 ล้านสี เปรียบเทียบได้กับการวาดรูปโดยใช้ดินสอสี 16.7 ล้านแท่ง ซึ่งก็ฟังดูมหาศาลแล้ว แต่ลองดูรูปต่อไปนี้กันครับ:

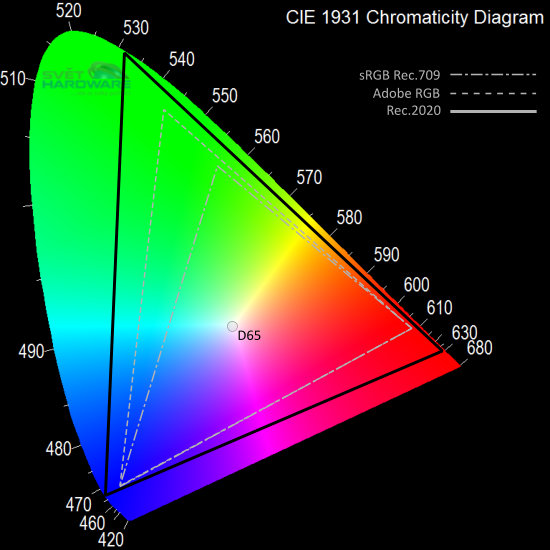

จากภาพคือขอบเขตสีที่ตามองเห็นได้ สามเหลี่ยมเล็กสุดคือ Color space แบบ sRGB (Standard RGB) จะเห็นได้ว่ากินพื้นที่ไปแค่ครึ่งเดียวจากทั้งหมด แถมจอตามบ้านทั่วๆไปยังทำได้ไม่เต็มพื้นที่อีกต่างหาก....

สามเหลี่ยมตรงกลางคือ Adobe RGB ซึ่งโปรนิยมใช้กัน สังเกตได้ว่ากินขอบเขตกว้างกว่า sRGB ไปอีกมาก....

ถามว่า แล้วทำไมไม่กำหนดมาตรฐานให้ครอบคลุมกว้างๆไปเลยล่ะ ? คำตอบก็มีทั้งเรื่องอุปกรณ์ ความนิยม การ Support ทาง Software และที่สำคัญคือเรื่องระดับสี เพราะ Adobe RGB ก็มีสีให้ระบาย 16.7 ล้านแท่งเท่าเดิม ยิ่งกระจายกว้างออกไป การไล่ระดับก็จะขาดความต่อเนื่องมากขึ้นเท่านั้น....

แต่ปัจจุบันเราสามารถผลิตจอที่ให้ขอบเขตสีกว้างๆให้ราคาถูกลงได้มากขึ้นเรื่อยๆ และการ์ดจอระดับพื้นๆก็สามารถสร้างสีมากกว่านั้นได้ตั้งนานแล้ว ดังนั้นมาตรฐานจอสมัยใหม่ จึงเข้าสู่ยุคใช้ขอบเขตสีที่กว้างขึ้น (สามเหลี่ยมใหญ่ในภาพ) และให้สีได้ 10-bit ต่อสี รวมกันเป็น 30-bit นั่นคือมีสีไว้ระบายถึง 1 พันล้านสี!!

โปรแกรมของ Adobe ใช้สี 30-bit ได้มานานแล้ว ในขณะที่ Format ภาพที่นิยมใช้ยังไม่มีตัวไหนรองรับ 10-bit แต่ BPG และ JPG ยุคใหม่ (2000 และ XR) รองรับแล้ว ถ้า WebP ของ Google (ซึ่งผมมองว่าเป็นตัวเต็งที่จะมาแทน JPG) รองรับเมื่อไหร่ก็น่าจะเริ่มต้นนับถอยหลังเข้าสู่ยุค 30-bit ได้เลย....

แต่ปัจจัยขับเคลื่อนที่แท้จริง ผมคิดว่าไม่ใช่ภาพนิ่งหรือเว็บไซต์ แต่เป็นหนัง เพราะจอระดับ 4K ขึ้นไป และเครื่องเล่น Blu-ray รุ่นใหม่ จะเริ่มรองรับมาตรฐานใหม่นี้แล้วครับ ใช้การเข้ารหัสด้วย x265 แผ่นหนังหนึ่งเรื่องจะมีขนาด 60-100GB จะเริ่มวางตลาดช่วงครึ่งหลังปีนี้ ซึ่งคุณภาพเหนือกว่า Blu-ray ยุคเดิมแบบเทียบกันไม่ได้เลย....

สิ่งที่จะเกิดขึ้นคือ จอภาพที่มาพร้อมกับ "มาตรฐาน" ที่ใช้งานกัน "แพร่หลาย" บวกคำโฆษณาเรื่อง 1 พันล้านสี บริษัทใหญ่ๆก็ต้องแข่งกันทำจอ 30-bit ให้ถูกลงเรื่อยๆ แพร่หลายขึ้นเรื่อยๆ เราจะเริ่มเห็นความแตกต่างเมื่อเปิดมีเดียที่เป็น 30-bit เทียบกับภาพ JPG ที่คุณถ่ายไว้ในตอนนี้ชัดขึ้นเรื่อยๆ ตามคุณภาพของจอที่ดีขึ้นเรื่อยๆในแต่ละปี และในอีก 5 หรือ 10 ปีข้างหน้า ถ้าคุณไม่ได้ถ่าย Raw เอาไว้ในตอนนี้ ก็ไม่สามารถกลับไปแปลงเป็นไฟล์ภาพ 30-bit ได้อีกแล้ว....

สิ่งเหล่านี้เกิดขึ้นแน่นอน แต่จะช้าหรือเร็วเท่านั้นล่ะครับ ;)

เหตุผลสำคัญมากที่คุณไม่ควรถ่ายเป็น JPG อีกแล้วในพศ.นี้

ก่อนอื่นต้องเท้าความก่อนว่าคอมพิวเตอร์ตั้งแต่สมัยโบราณ เราเริ่มมาจากจอขาวดำ (สี 1 บิต) และเริ่มมีสีจาก 4 สี (CGA) ไล่มาเป็น EGA และ VGA จนปัจจุบันมาถึง True color ซึ่งมีสี 24-bit และอยู่ตัวมาเป็นยี่สิบปีได้แล้วมั้ง....

สีแบบ 24-bit (Channel ละ 8 bit ไม่นับ Alpha) เป็นมาตรฐานที่แพร่หลาย สามารถไล่ระดับสีได้ 16.7 ล้านสี เปรียบเทียบได้กับการวาดรูปโดยใช้ดินสอสี 16.7 ล้านแท่ง ซึ่งก็ฟังดูมหาศาลแล้ว แต่ลองดูรูปต่อไปนี้กันครับ:

จากภาพคือขอบเขตสีที่ตามองเห็นได้ สามเหลี่ยมเล็กสุดคือ Color space แบบ sRGB (Standard RGB) จะเห็นได้ว่ากินพื้นที่ไปแค่ครึ่งเดียวจากทั้งหมด แถมจอตามบ้านทั่วๆไปยังทำได้ไม่เต็มพื้นที่อีกต่างหาก....

สามเหลี่ยมตรงกลางคือ Adobe RGB ซึ่งโปรนิยมใช้กัน สังเกตได้ว่ากินขอบเขตกว้างกว่า sRGB ไปอีกมาก....

ถามว่า แล้วทำไมไม่กำหนดมาตรฐานให้ครอบคลุมกว้างๆไปเลยล่ะ ? คำตอบก็มีทั้งเรื่องอุปกรณ์ ความนิยม การ Support ทาง Software และที่สำคัญคือเรื่องระดับสี เพราะ Adobe RGB ก็มีสีให้ระบาย 16.7 ล้านแท่งเท่าเดิม ยิ่งกระจายกว้างออกไป การไล่ระดับก็จะขาดความต่อเนื่องมากขึ้นเท่านั้น....

แต่ปัจจุบันเราสามารถผลิตจอที่ให้ขอบเขตสีกว้างๆให้ราคาถูกลงได้มากขึ้นเรื่อยๆ และการ์ดจอระดับพื้นๆก็สามารถสร้างสีมากกว่านั้นได้ตั้งนานแล้ว ดังนั้นมาตรฐานจอสมัยใหม่ จึงเข้าสู่ยุคใช้ขอบเขตสีที่กว้างขึ้น (สามเหลี่ยมใหญ่ในภาพ) และให้สีได้ 10-bit ต่อสี รวมกันเป็น 30-bit นั่นคือมีสีไว้ระบายถึง 1 พันล้านสี!!

โปรแกรมของ Adobe ใช้สี 30-bit ได้มานานแล้ว ในขณะที่ Format ภาพที่นิยมใช้ยังไม่มีตัวไหนรองรับ 10-bit แต่ BPG และ JPG ยุคใหม่ (2000 และ XR) รองรับแล้ว ถ้า WebP ของ Google (ซึ่งผมมองว่าเป็นตัวเต็งที่จะมาแทน JPG) รองรับเมื่อไหร่ก็น่าจะเริ่มต้นนับถอยหลังเข้าสู่ยุค 30-bit ได้เลย....

แต่ปัจจัยขับเคลื่อนที่แท้จริง ผมคิดว่าไม่ใช่ภาพนิ่งหรือเว็บไซต์ แต่เป็นหนัง เพราะจอระดับ 4K ขึ้นไป และเครื่องเล่น Blu-ray รุ่นใหม่ จะเริ่มรองรับมาตรฐานใหม่นี้แล้วครับ ใช้การเข้ารหัสด้วย x265 แผ่นหนังหนึ่งเรื่องจะมีขนาด 60-100GB จะเริ่มวางตลาดช่วงครึ่งหลังปีนี้ ซึ่งคุณภาพเหนือกว่า Blu-ray ยุคเดิมแบบเทียบกันไม่ได้เลย....

สิ่งที่จะเกิดขึ้นคือ จอภาพที่มาพร้อมกับ "มาตรฐาน" ที่ใช้งานกัน "แพร่หลาย" บวกคำโฆษณาเรื่อง 1 พันล้านสี บริษัทใหญ่ๆก็ต้องแข่งกันทำจอ 30-bit ให้ถูกลงเรื่อยๆ แพร่หลายขึ้นเรื่อยๆ เราจะเริ่มเห็นความแตกต่างเมื่อเปิดมีเดียที่เป็น 30-bit เทียบกับภาพ JPG ที่คุณถ่ายไว้ในตอนนี้ชัดขึ้นเรื่อยๆ ตามคุณภาพของจอที่ดีขึ้นเรื่อยๆในแต่ละปี และในอีก 5 หรือ 10 ปีข้างหน้า ถ้าคุณไม่ได้ถ่าย Raw เอาไว้ในตอนนี้ ก็ไม่สามารถกลับไปแปลงเป็นไฟล์ภาพ 30-bit ได้อีกแล้ว....

สิ่งเหล่านี้เกิดขึ้นแน่นอน แต่จะช้าหรือเร็วเท่านั้นล่ะครับ ;)